(ChatGPT生成)

NVIDIAの株を買いました

株式分割前に1200ドルで1株購入しました。日本円で19万円ほど。正直かなり痛いですね。

今後、今よりは円高になるでしょうし。

正直、高値づかみという気もするのですが、まぁ、その時はその時で。

AI生成用のロジックLSIは各社が開発にしのぎを削ってますが、しばらくはNVIDIAの独壇場でしょう。

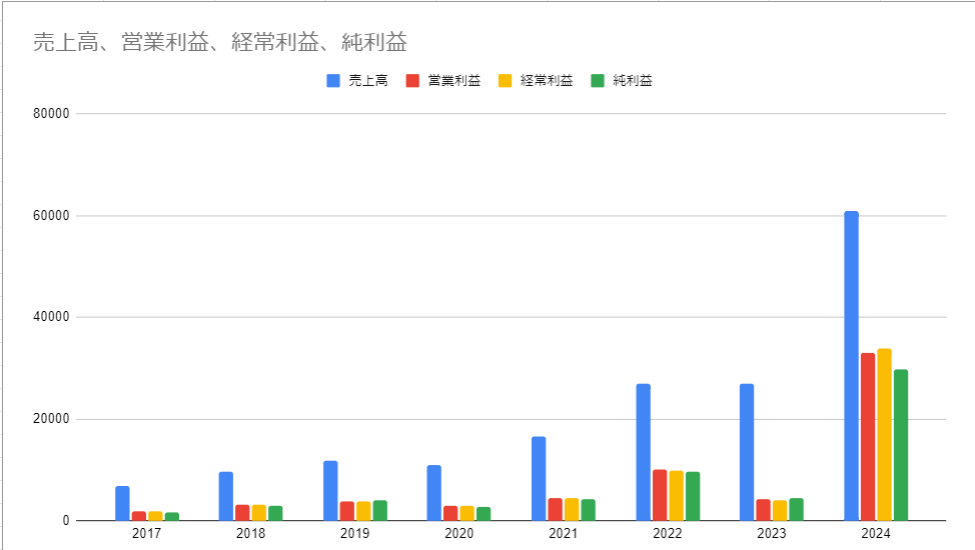

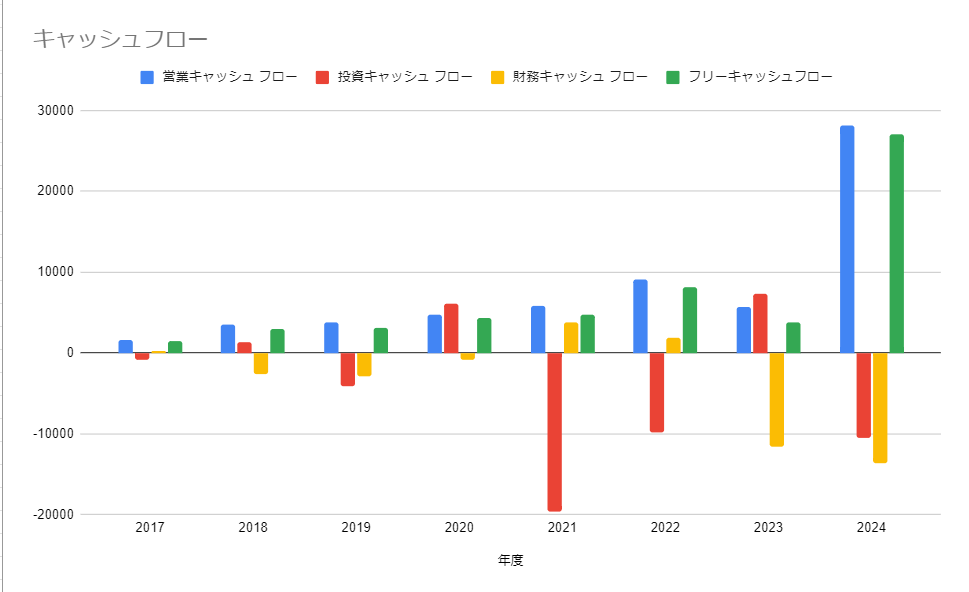

業績

2024年にかけて、営業利益がとんでもないことになっているのが分かります。

粗利益率が70%を超えているそうです。

大規模言語モデルについて

オープンAIのChatGPTが有名ですが、アメリカは生成AIブームです。マイクロソフトはオープンAIとがっちり手を組んでいるから良いとして、GoogleやMeta Amazon イーロンマスクのXなども必死で後を追いかけています。

個人的には、生成AIがすごいと言うよりも、大規模言語モデルで生成AIを作るとすごい性能が出るというのが本質だと思っています。

最近のAIは、大規模言語モデルも画像認識も、ディープラーニングという技術を使っています。

ディープラーニングは、学習と推論という過程があります。

作成したAIモデルに対して、膨大な、画像であったり、音声であったり、テキストデータだったりをつかって学習をさせます。このときに、NVIDIAのGPUが使われます。

学習を終えてはじめて、AIモデルは仕事をするようになります。

例えば、様々な動物の画像の中から猫の画像だけを判断したり、あるいは、質問(プロンプト)を与えると、文章で答えを返してくれたりといった。この過程を推論と呼びます。

推論は学習ほど計算能力を必要としません。

学習にはGPUを数百個つかっても、推論はスマホ1つで十分だと言われていました。

ところが、ChatGPTなどの大規模言語モデルになると推論にもGPUが必要になってきました。

なぜ、NVIDIAのGPUなのか

ITガジェットにはそれなりに詳しい自負があるのですが、なぜ、AIでNVIDIAのGPUばかり使われているのかよく理解していませんでした。

NVIDIAのGPUがAIとか科学技術計算でよく使われるのは、NVIDIAのハードウェアが優れているからだと思っていて、それも事実なのですが、本質的な問題として、大規模AIモデルを学習させるには、NVIDIAの開発したCUDAというライブラリが必須で、CUDAはNVIDIAのGPUでしか動かないということです。

2012年にALEX NETという画像認識のニューラルネットワークが、画像認識のコンベンションで2位に大差を付けて優勝したらしいです。ALEX NETはNVIDIAのGPUとCUDAで構成されていました。

以来、AIをやるならNVIDIAのGPUとCUDAでないとならないという流れが出て今に至るそうです。

世界中の研修者がこぞってCUDAで開発をしたため、CUDA上にAI関連の膨大なライブラリが構築されてしまい、今更、他の開発環境に移行できないそうです。

NVIDIAというのはハードウェアの会社であると同時にソフトウェアの会社でもあると言うことです。

このあたり、アップルに似ている気がしますね。アップルもiPhoneやMacのOSはもちろん、ハードウェア 最近はCPUも自社で設計しています。

アップル製品は、WindowsやAndroidと比べて、自社のハードにソフトが最適化されているため、前者に比べて快適に動く。あるいは安定しているようです。

ユーザーインターフェイスにしても、アプリにしても、アップルのそれは他社と違って一貫性があり、洗練されています。

最後に

AI界隈における、NVIDIAの天下はまだまだ続きそうです。

莫大な労力と資金を投入したけれど、AIはまだまだ使えない みたいなことになって、AIバブルが弾けたら色々変わってくるんでしょうけれど。

最後に、グチを少々。

NVIDIAのGPUが、グラフィックのみならず、科学技術計算やAIの学習(ディープラーニング)に使われているのは数年前から知っていました。NVIDIAのGPUで計算を行うためのライブラリ CUDAの存在も知っていました。

2020年から2021年にかけて、株式分割をしたタイミングでアップルの株を7株購入しました。110ドルくらいでした。2020年、NVIDIA株は100ドルくらいで買えたんですよね。NVIDIAのGPUについて、それなりに知っていたにもかかわらず、なぜ、買わなかったのか。なんかがっくりです。

そういえば、今、インテルの株を10株ほど持ってます。ゲルシンゲーCEOの下、インテルが復活して、将来的に値上がりしてくれたらうれしいんですけどね。

コメント